Nos últimos meses, a comunidade da inteligência artificial tem sido alvo de um aceso debate desencadeado por dois influentes artigos de investigação publicados pela Apple. O primeiro, illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (outubro de 2024), e o segundo, "A Ilusão do Pensamento" (junho de 2025), questionaram as alegadas capacidades de raciocínio dos modelos de linguagem de grande dimensão, provocando reacções mistas em todo o sector.

Como já analisado na nossa análise anterior sobre «A Ilusão do Progresso: Simular a Inteligência Artificial Geral Sem a Alcançar», a questão do raciocínio artificial toca o cerne do que consideramos inteligência nas máquinas.

Os investigadores da Apple efectuaram uma análise sistemática de Modelos de Raciocínio Amplos (LRM) - os modelos que geram traços de raciocínio detalhados antes de fornecerem uma resposta. Os resultados foram surpreendentes e, para muitos, alarmantes.

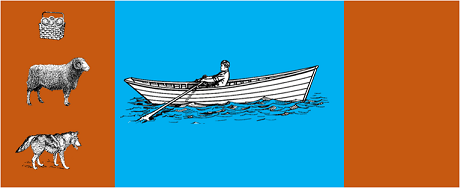

O estudo submeteu os modelos mais avançados a puzzles algorítmicos clássicos, tais como:

Os resultados mostraram que mesmo pequenas alterações na formulação do problema conduzem a variações significativas no desempenho, sugerindo uma fragilidade preocupante no raciocínio. Conforme relatado na cobertura do AppleInsidero desempenho de todos os modelos diminui quando apenas são alterados os valores numéricos nas perguntas do teste de referência GSM-Symbolic".

A resposta da comunidade de IA não tardou a chegar. Alex Lawsen da Open Philanthropy, em colaboração com Claude Opus da Anthropic, publicou uma refutação pormenorizada intitulada "A ilusão de pensar".contestando as metodologias e as conclusões do estudo da Apple.

Quando Lawsen repetiu os testes com metodologias alternativas - pedindo aos modelos que gerassem funções recursivas em vez de listar todos os movimentos - os resultados foram dramaticamente diferentes. Modelos como Claude, gemini e GPT resolveram corretamente problemas da Torre de Hanói com 15 registos, muito para além da complexidade em que a Apple reportou zero sucessos.

Gary Marcusum crítico de longa data das capacidades de raciocínio dos LLMs, aceitou as conclusões da Apple como uma confirmação da sua tese de 20 anos. De acordo com Marcus, os licenciados em Direito continuam a debater-se com a "mudança de distribuição" - a capacidade de generalizar para além dos dados de formação - embora continuem a ser "bons solucionadores de problemas que já foram resolvidos".

O debate também se estendeu a comunidades especializadas, como LocalLlama no Redditonde programadores e investigadores debatem as implicações práticas dos modelos de código aberto e da implementação local.

Este debate não é meramente académico. Tem implicações diretas para:

Conforme salientado em várias conhecimentos técnicoshá uma necessidade crescente de abordagens híbridas que combinem:

Exemplo trivial: um assistente de IA que ajuda na contabilidade. O modelo de linguagem compreende quando se pergunta "quanto é que gastei em viagens este mês?" e extrai os parâmetros relevantes (categoria: viagens, período: este mês). Mas a consulta SQL que consulta a base de dados, calcula a soma e verifica as restrições fiscais? Isso é feito por código determinístico, não pelo modelo neural.

Não passou despercebido aos observadores o facto de o documento da Apple ter sido publicado pouco antes da WWDC, o que levanta questões sobre as motivações estratégicas. Conforme aanálise do 9to5Mac"o momento em que o documento da Apple foi publicado - mesmo antes da WWDC - levantou algumas sobrancelhas. Foi um marco de pesquisa ou um movimento estratégico para reposicionar a Apple no cenário mais amplo da IA?"

O debate desencadeado pelos documentos da Apple recorda-nos que ainda estamos na fase inicial da compreensão da inteligência artificial. Como salientámos no nosso artigo anteriora distinção entre simulação e raciocínio autêntico continua a ser um dos desafios mais complexos do nosso tempo.

A verdadeira lição não é se os LLMs podem ou não "raciocinar" no sentido humano do termo, mas sim como podemos construir sistemas que explorem os seus pontos fortes e compensem as suas limitações. Num mundo em que a IA já está a transformar sectores inteiros, a questão já não é saber se estas ferramentas são "inteligentes", mas sim como utilizá-las de forma eficaz e responsável.

O futuro da IA empresarial não residirá provavelmente numa única abordagem revolucionária, mas na orquestração inteligente de várias tecnologias complementares. E, neste cenário, a capacidade de avaliar de forma crítica e honesta as capacidades das nossas ferramentas torna-se numa vantagem competitiva.

Últimos desenvolvimentos (janeiro de 2026)

A OpenAI lança o o3 e o o4-mini: Em 16 de abril de 2025, a OpenAI lançou publicamente o o3 e o o4-mini, os modelos de raciocínio mais avançados da série o. Esses modelos agora podem usar ferramentas de forma ativa, combinando pesquisa na web, análise de ficheiros, raciocínio visual e geração de imagens. O o3 estabeleceu novos recordes em benchmarks como Codeforces, SWE-bench e MMMU, enquanto o o4-mini otimiza o desempenho e os custos para tarefas de raciocínio de alto volume. Os modelos demonstram capacidade de "pensamento com imagens", transformando visualmente o conteúdo para análises mais aprofundadas.

DeepSeek-R1 agita a indústria de IA: Em janeiro de 2025, a DeepSeek lançou o R1, um modelo de raciocínio de código aberto que alcançou desempenho comparável ao OpenAI o1 com um custo de treinamento de apenas US$ 6 milhões (contra centenas de milhões dos modelos ocidentais). O DeepSeek-R1 demonstra que as capacidades de raciocínio podem ser estimuladas através da aprendizagem por reforço pura, sem necessidade de demonstrações humanas anotadas. O modelo tornou-se a aplicação gratuita n.º 1 na App Store e no Google Play em dezenas de países. Em janeiro de 2026, a DeepSeek publicou um artigo expandido de 60 páginas que revela os segredos do treinamento e admite candidamente que técnicas como Monte Carlo Tree Search (MCTS) não funcionaram para o raciocínio geral.

A Anthropic atualiza a «Constituição» de Claude: Em 22 de janeiro de 2026, a Anthropic publicou uma nova constituição de 23 000 palavras para Claude, passando de uma abordagem baseada em regras para uma baseada na compreensão dos princípios éticos. O documento torna-se a primeira estrutura de uma grande empresa de IA a reconhecer formalmente a possibilidade de consciência ou estatuto moral da IA, afirmando que a Anthropic se preocupa com o «bem-estar psicológico, sentido de identidade e bem-estar» de Claude.

O debate intensifica-se: Um estudo de julho de 2025 replicou e refinou os benchmarks da Apple, confirmando que os LRM ainda apresentam limitações cognitivas quando a complexidade aumenta moderadamente (cerca de 8 discos na Torre de Hanói). Os investigadores demonstraram que isso não depende apenas de restrições de saída, mas também de limites cognitivos reais, evidenciando que o debate está longe de estar encerrado.

Para obter informações sobre a estratégia de IA da sua organização e a implementação de soluções sólidas, a nossa equipa de especialistas está disponível para consultas personalizadas.